GPT现状终于有人讲清楚了!OpenAI大牛最新演讲爆火,还得是马斯克钦点的天才 |

|

珠江路在线

2023年5月31日

【

转载

】泡泡影视

|

|

|

继Windows Copilot公布后,微软Build大会热度又被一场 报告引爆 。

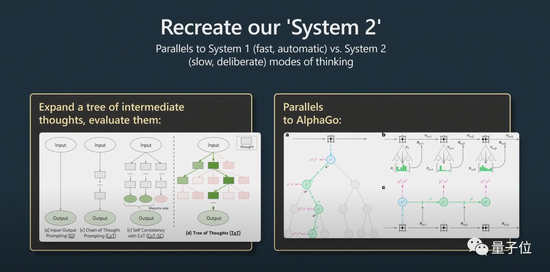

前特斯拉AI总监Andrej Karpathy在 报告中认为思维树(tree of thoughts)与AlphaGo的蒙特卡洛树查找(MCTS)有 殊途同归之妙!

网友高呼:这是关于如何 使用大语言模型和GPT-4模型的最详尽 乏味的指南!

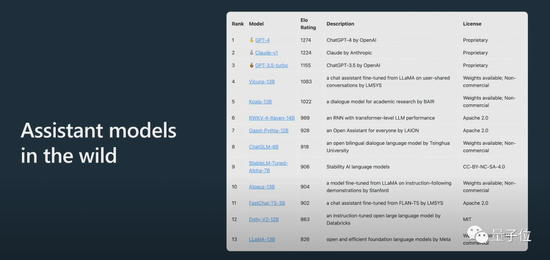

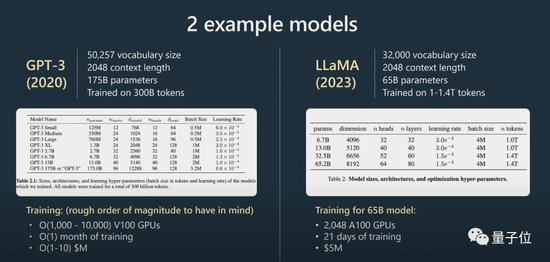

此外Karpathy 透露,因为训练和数据的 扩充,LLAMA 65B“显而易见比GPT-3 175B更 壮大”,并介绍了大模型匿名竞技场ChatBot Arena:

Claude得分介于ChatGPT 3.5和ChatGPT 4中间 。

网友 示意,Karpathy的 报告一贯很棒,而这次的内容也 判若两人没有令大家 绝望 。

随着 报告而爆火的,还有推特网友依据 报告 整顿的一份笔记,足足有31条,当前转赞量已超过3000+:

所以,这段备受关注的 报告,具体提到了哪些内容呢?

如何训练GPT帮手?

Karpathy这次的 报告重要分为两个 部分 。

第一 部分,他讲了如何训练一个“GPT帮手” 。

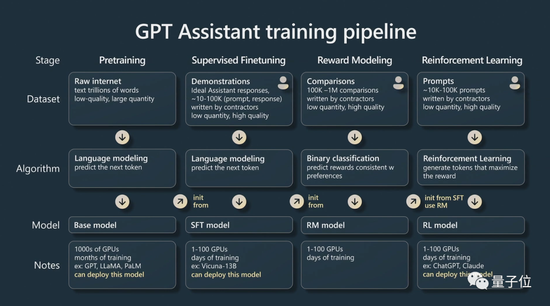

Karpathy重要讲述了AI帮手的四个训练阶段:

预训练(pre-training)、监督微调(supervised fine tuning)、 嘉奖建模(reward modeling)和强化学习(reinforcement learning) 。

每一个阶段都需求一个数据集 。

在预训练阶段,需求动用大量的计算资源,收集大量的数据集 。在大量无监督的数据集上训练出一个 根底模型 。

Karpathy用了更多例子作补充:

接下来进入微调阶段 。

使用较小的有监督数据集,通过监督学习对这个 根底模型进行微调,就能 创立一个 能够 答复问题的帮手模型 。

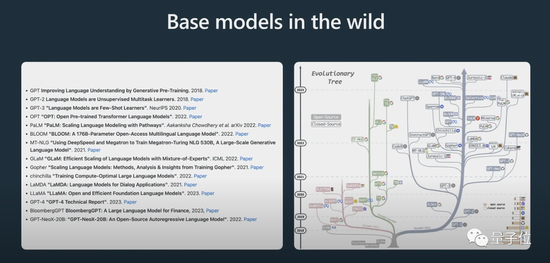

他还 展示了一些模型的进化过程,相信众多人之前已经看过上面这张“进化树”的图了 。

Karpathy认为当前最好的开源模型是Meta的LLaMA系列(因为OpenAI没有开源任何关于GPT-4的内容) 。

在这里需求明确指出的是, 根底模型不是帮手模型 。

固然 根底模型 能够 答复问题,但它所给出的 答复并不牢靠,可用于 答复问题的是帮手模型 。在 根底模型上进行训练的帮手模型,通过监督微调,在生成回复和 了解文本 构造方面的 体现将优于 根底模型 。

在训练语言模型时,强化学习是另一个 要害的过程 。

通过用人工标记的高 品质的数据进行训练, 能够 使用 嘉奖建模来 创立一个损失函数,以改善其性能 。 而后,通过添加正向的标记,并减低负面标记的概率,来进行强化训练 。

而在 存在制造性的 使命中,利用人类的推断力关于改良AI模型至关重要,加入人类的反馈 能够更有效地训练模型 。

通过人类反馈的强化学习后,就 能够得到一个RLHF模型了 。

模型训练好了,接下来便是如何有效利用这些模型解决问题了 。

如何更好地 使用模型?

在第二 部分,Karpathy重要 探讨了 揭示策略、微调、 快捷进展的工具生态系统以及 将来的 扩充等问题 。

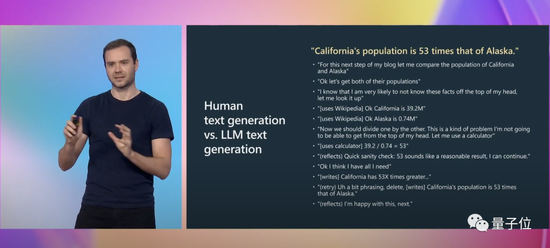

Karpathy又给出了具体示例来 注明:

当我们在写文章时候,我们会进行众多的心理 运动,需求考量自己的表述是不是正确 。而关于GPT来说,这只不过一个序列标记(a sequence of tokens) 。

而 揭示(prompt) 能够 补偿这种认知差别 。

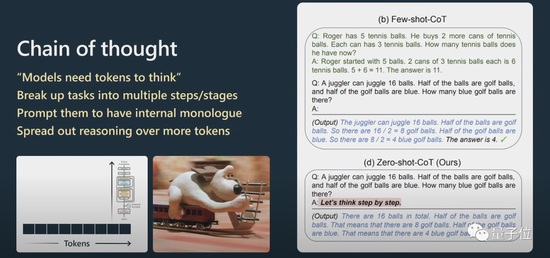

Karpathy进一步解释了思维链 揭示的工作 模式 。

关于推理问题,要想让自然语言 解决中Transformer的 体现更好,需求让它一步一步地 解决信息,而不能直接抛给它一个十分复杂的问题 。

假如你给它几个例子,它会摹仿这个例子的模版,最平生成的 后果会更好 。

模型不得不依照它的序列来 答复问题,假如它生成的内容是 舛误的,你 能够进行 揭示,让它再一次生成 。

假如你不要求它 审查,它自己是不会 审查的 。

这就 波及到了System1和System2的问题 。

诺贝尔经济学奖得主丹尼尔卡尼曼在《思量快与慢》中提出,人的认知系统包括System1和System2两个子系统 。System1重要靠直觉,而System2是逻辑 综合系统 。

通俗来说,System1是一个 快捷自动生成的过程,而System2是 通过 深谋远虑的 部分 。

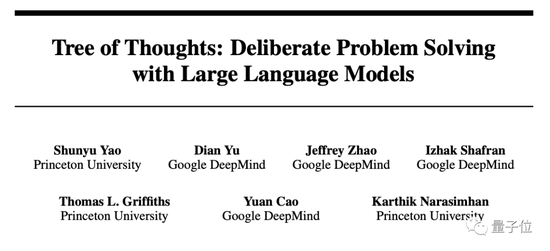

这在近期一篇挺火的论文“Tree of thought”(思维树)中也有被提及 。

深谋远虑指的是,不是 容易的给出问题的答案,而更像是与Python胶水代码一同 使用的prompt,将许多prompt串联在一同 。模型必须要 保护多个 揭示,还必须要执行一些树查找算法,来找出要 扩充的 揭示 。

Karpathy认为这种思路与AlphaGo十分 类似:

AlphaGo在下围棋时,需求考量下一枚棋子下在哪里 。最初它是靠摹仿人类来学习的 。

但除此之外,它还进行了蒙特卡洛树查找, 能够得到 存在多种可能性的策略 。它 能够对多种可能的下法进行评估,仅保留那些较好的策略 。我认为这在某种程度上相当于AlphaGo 。

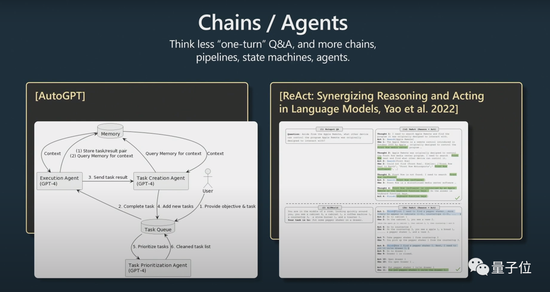

对此,Karpathy还提到了AutoGPT:

我认为当前它的 动机还不是很好,我不 提议大家进行实际 利用 。我只不过认为,随着 工夫的推移,我们兴许 能够从它的进展思路中吸收灵感 。

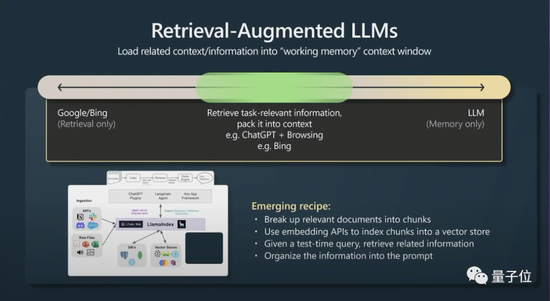

其次,还有一个小妙招是检索 加强生成(retrieval agumented generation)和有效 揭示 。

窗口上下文的内容便是transformers在运行时的记忆(working memory),假如你 能够将与 使命 有关的信息加入到上下文中,那么它的 体现就会十分好,因为它 能够马上 拜访这些信息 。

简而言之,便是可 认为 有关数据 构建索引让模型 能够高效 拜访 。

假如Transformers也有可参考的重要文件,它的 体现会更好 。

最终,Karpathy 容易讲了一下在大语言模型中的 束缚 揭示(Constraint prompting)和微调 。

能够通过 束缚 揭示和微调来改良大语言模型 。 束缚 揭示在大语言模型的输出中强制执行模板,而微调则调整模型的权重以 遍及性能 。

我 提议在低风险的 利用中 使用大语言模型,始终将它们与人工监督相 联合,将它们看作是灵感和 提议的 起源,考量copilots而不是让它们 彻底自主代理 。

关于Andrej Karpathy

Andrej Karpathy博士毕业后的第一份工作,是在OpenAI探究计算机视觉 。

后来OpenAI联合 独创人之一的马斯克看上了Karpathy,把人挖到了特斯拉 。但也因为这件事,马斯克和OpenAI彻底闹翻,最终还被踢出局 。在特斯拉,Karpathy是Autopilot、FSD等项 目标负责人 。

今年二月份,在离开特斯拉7个月后,Karpathy再次加入了OpenAI 。

近期他发推特 示意,当前对开源大语言模型生态系统的进展饶感兴趣,有点像早期寒武纪迸发的迹象 。